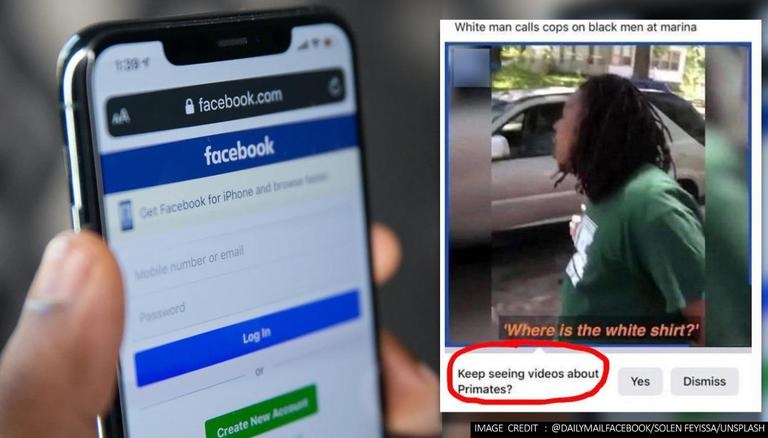

Theo The New York Times, những người dùng sau khi xem một video được đăng bởi Daily Mail với sự xuất hiện của người da màu vào hôm 27/6 nhận được một gợi ý tự động từ hệ thống. Facebook hỏi họ rằng: "Bạn có muốn xem thêm video về linh trưởng không?".

Trong tình huống này, hệ thống trí tuệ nhân tạo của Facebook đã nhầm lẫn người da màu với loài linh trưởng.

|

| Bài đăng từ Daily Mail và dòng chữ được khoanh đỏ: "Bạn có muốn xem thêm video về linh trưởng không?". Ảnh: Facebook/Unsplash. |

Trả lời The Verge, đại diện Facebook cho biết sau khi ghi nhận sự việc, đã vô hiệu hoá hệ thống gợi ý chủ đề.

"Đây là một sai lầm không thể chấp nhận được. Đội ngũ kỹ thuật đang cố gắng để cải thiện hệ thống AI của Facebook và chúng tôi thật lòng xin lỗi những cá nhân cảm thấy bị xúc phạm bởi gợi ý tự động kia", đại diện này chia sẻ.

Sự cố trên là ví dụ mới nhất về việc các hệ thống trí tuệ nhân tạo (AI) mắc sai lầm trong việc nhận diện giới tính hay màu da của một người.

Vào năm 2015, Google xin lỗi vì ứng dụng Google Hình ảnh của họ gọi người da màu là gorilla, hay loài khỉ đột. Từ năm 2020, Facebook đã nghiên cứu về việc liệu các thuật toán của họ có "phân biệt chủng tộc" với các màu da khác hay không. Thuật toán AI này còn dùng cho cả ứng dụng Instagram.

Ủy ban Thương mại Liên bang Hoa Kỳ (FTC) cảnh báo rằng những công nghệ trí tuệ nhân tạo thể hiện việc phân biệt chủng tộc có thể vi phạm các điều luật bảo vệ người tiêu dùng.

"Hãy kiểm soát công nghệ của bạn hoặc FTC sẽ làm điều đó", Elisa Jillson, công tố viên của Uỷ ban chia sẻ trên trang web của cơ quan.