Khi Giám đốc marketing Phil Schiller lên sân khấu và nói về khả năng chụp ảnh của iPhone 11, ông khoe rằng chiếc điện thoại này sẽ có "khả năng nhiếp ảnh điện toán cực kỳ hiện đại". Rất có thể Google cũng sẽ nói điều tương tự khi ra mắt chiếc Pixel 4 trong tuần tới.

Nhiếp ảnh điện toán (computational photography) chính là cụm từ được quan tâm nhất trong vài năm trở lại đây. Bằng sự kết hợp giữa trí tuệ nhân tạo, khả năng tính toán và tối ưu, nhiếp ảnh điện toán mang lại những bức ảnh rất ấn tượng, đôi khi vượt qua cả hạn chế về cảm biến hay ống kính.

Vậy chính xác thì nhiếp ảnh điện toán là gì?

Nói ngắn gọn thì đó là cách chiếc smartphone đưa bức ảnh qua một quy trình xử lý bằng phần mềm, để có thể làm ra được bức ảnh tốt hơn. Quy trình đó có thể mang lại bức ảnh nét hơn, hoặc sáng hơn khi chụp buổi tối. Nhiếp ảnh điện toán rất quan trọng với smartphone, bởi cảm biến lẫn ống kính máy ảnh trên smartphone vốn có kích thước rất nhỏ, khó có thể thu hình ảnh tốt như máy ảnh chuyên dụng.

Những tính năng chụp đêm rất ấn tượng như Night Mode trên iPhone 11, hay Night Sight trên điện thoại Google Pixel chính là sản phẩm của nhiếp ảnh điện toán.

Những ứng dụng đầu tiên: Chụp toàn cảnh và HDR

Thực tế nhiếp ảnh điện toán đã được tích hợp vào smartphone từ lâu. Một trong những tính năng đầu tiên có ứng dụng nhiếp ảnh điện toán là HDR, viết tắt của "dải động rộng". Do kích cỡ cảm biến trên smartphone khá nhỏ, chúng rất khó thu về dải sáng, tối đầy đủ trong một khung cảnh.

Các hãng smartphone khắc phục vấn đề bằng cách cho máy chụp hai hoặc nhiều tấm ảnh ở các mức độ sáng khác nhau, sau đó ghép chúng lại thành một bức ảnh duy nhất. Nhờ vậy, bức ảnh cuối cùng thể hiện được chi tiết của cả vùng sáng và vùng tối trong ảnh.

|

| Chế độ HDR+ của Google được đánh giá cao khi giữ lại được chi tiết, màu sắc tự nhiên hơn so với chế độ HDR trước đó. Ảnh: The Next Web. |

Tất nhiên, phương thức này không cho ra những bức ảnh hoàn hảo như mắt người nhìn thấy. Đôi khi ảnh chụp từ HDR trông rất giả tạo. Do chụp nhiều ảnh cùng lúc, thỉnh thoảng sẽ có hiện tượng "giật hình", khi một chủ thể trong hình bị kéo giãn hoặc không còn trọn vẹn vì đang di chuyển.

Chế độ HDR được cải tiến mạnh sau khi Apple tích hợp vào iPhone 4 năm 2010. Vài năm sau, Google đưa HDR lên một tầm mới khi giới thiệu chế độ HDR Plus.

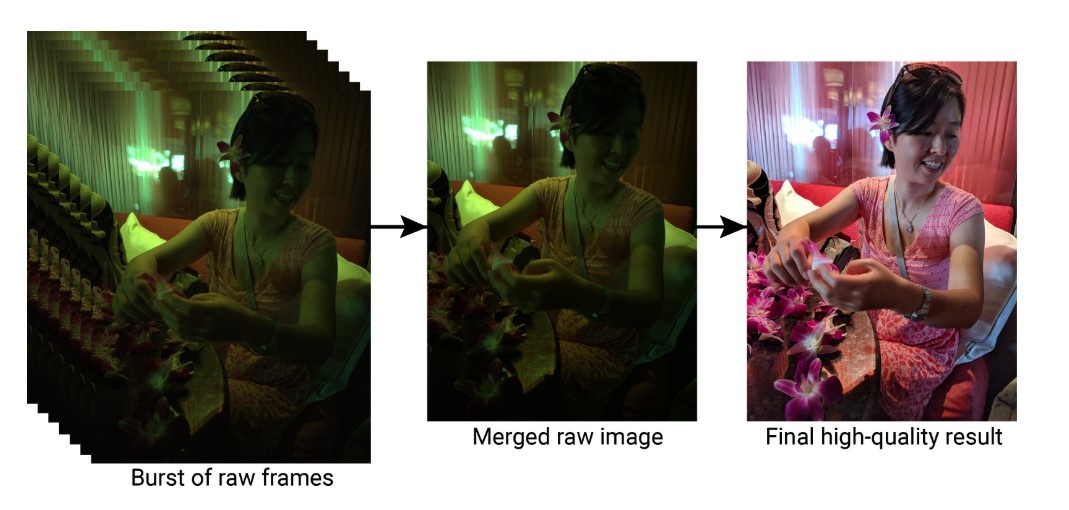

Thay vì chụp vài tấm ảnh từ tối đến sáng, chế độ này chụp thật nhiều bức ảnh tối sau đó ghép vào với nhau để có ảnh vừa sáng, vừa đúng màu và thật hơn. Về cơ bản, chế độ Smart HDR trên thế hệ iPhone 2018 cũng hoạt động giống như vậy.

Mỗi bức ảnh chụp với HDR+ thực tế là một ảnh ghép, được tạo bằng cách chụp và ghép hàng loạt ảnh ngắn với độ phân giải đầy đủ.

Google mô tả cách hoạt động của HDR+.

Chế độ chụp toàn cảnh (panorama) cũng là một ứng dụng của nhiếp ảnh điện toán. Khi người dùng kéo máy dọc theo khung hiện trên màn hình, thực tế chiếc smartphone đã chụp hàng loạt bức ảnh, sau đó "khâu" chúng lại với nhau.

Việc nối các bức ảnh không hề đơn giản, bởi smartphone phải đảm bảo độ sáng, màu sắc và các chi tiết khớp nối với nhau. Tuy nhiên, smartphone ngày nay đủ khả năng làm điều đó, cho phép chúng ta xoay máy ảnh một cách đơn giản để chụp một tấm hình toàn cảnh.

Biến không gian 2D thành 3D

Đây cũng là một thành tựu đáng kể của nhiếp ảnh điện toán. Các dòng smartphone cao cấp thường được trang bị nhiều máy ảnh, có khả năng phân tích và "bóc tách" từng lớp không gian trong ảnh. Tiên tiến hơn, Google có thể làm được điều đó chỉ với một camera trên các dòng máy Pixel.

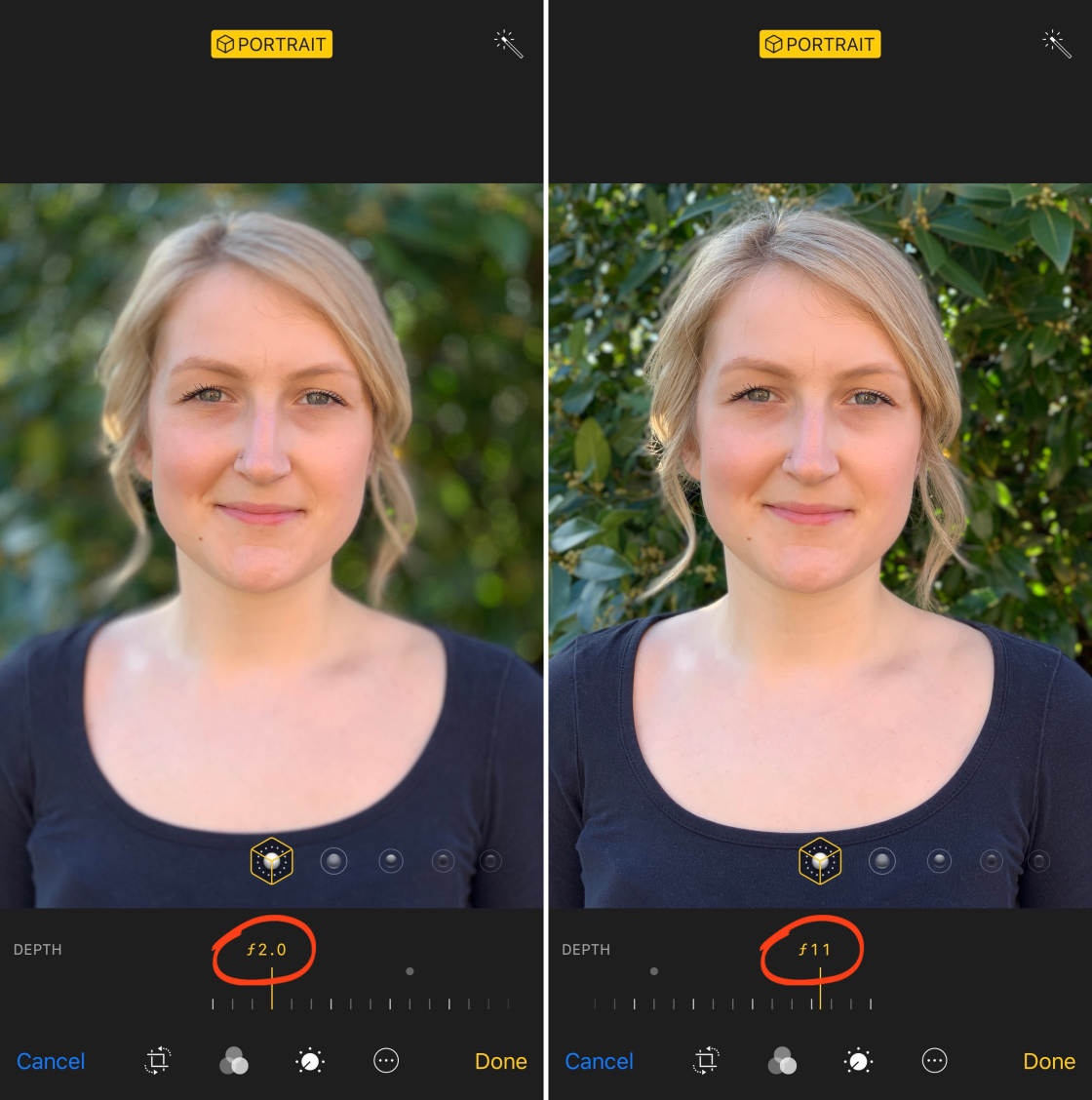

Lợi ích lớn nhất của tính năng này là chế độ chụp chân dung. Ảnh chụp ở chế độ này sẽ làm mờ phần nền, qua đó làm nổi bật chủ thể. Các dòng máy ảnh cũng có thể tạo hiệu ứng này, nhưng hoàn toàn là từ các đặc tính vật lý. Trong khi đó, điện thoại sử dụng toán học.

|

| Những chiếc iPhone mới có thể nhận biết được khuôn mặt chủ thể và phần nền, qua đó tạo hiệu ứng chụp ảnh xóa phông. Ảnh: iPhone Photography School. |

Để tách được chủ thể khỏi phần nền, chiếc điện thoại phải dựng lên một bản đồ độ sâu, cho biết từng đối tượng trong hình ở cách camera bao xa. Ngoài ra, chiếc smartphone cũng cần nhận biết được những khuôn mặt có trong hình. Từ dữ liệu đó, máy có thể làm mờ phần nền và giữ phần khuôn mặt chủ thể nét.

Ngoài chế độ xóa phông, kỹ thuật này còn được dùng cho các tính năng như hiệu ứng đèn sân khấu trên iPhone. Kỹ thuật sử dụng AI để nhận biết vật thể trong hình có thể giúp các cỗ máy phân loại người, loại cảnh chụp trong từng hình.

Tăng khả năng nhìn trong đêm

Từ chức năng HDR Plus, Google đã phát triển thêm để ra mắt Night Sight. Nguyên lý hoạt động của chúng giống nhau: chụp nhiều bức ảnh tĩnh, chồng lên nhau và để cho máy xử lý nhằm đem lại bức ảnh sáng hơn hẳn.

Nhờ tính năng này, chiếc điện thoại của Google thậm chí mang lại những bức ảnh chụp còn sáng hơn nhiều camera chuyên nghiệp. Tất nhiên, cảm biến trên chiếc máy ảnh Canon vượt trội so với Pixel, nhưng chiếc smartphone lại có thể kết hợp nhiều bức ảnh chỉ trong giây lát.

|

| Chế độ chụp đêm trên iPhone 11 có thể cải thiện hình ảnh chụp đêm rất nhiều. Ảnh: 9to5Mac. |

Chế độ chụp đêm đã tạm khắc phục điểm yếu lớn nhất của smartphone: khả năng ghi lại hình ảnh trong những môi trường tối, vốn rất phổ biến ở ngoài đời. Tất nhiên, ảnh chụp sẽ không thể chi tiết, ít nhiễu như khi sử dụng máy ảnh để chụp phơi sáng.

Night Sight rất quan trọng, bởi nó đem lại hình ảnh ấn tượng bằng phần mềm mà trước đó chỉ có thể đạt được bằng phần cứng.

The Verge đánh giá tính năng Night Sight trên Google Pixel 3.

Dù vậy, đây vẫn là chế độ rất hữu ích. Sau Google, lần lượt Samsung, Huawei cũng tích hợp chế độ chụp đêm trên điện thoại của mình, và gần đây nhất là Apple với Night Mode iPhone 11.

Ngoài ra, Apple còn giới thiệu một tính năng khác có tên Deep Fusion. Nếu như Night Mode được ứng dụng chủ yếu để tăng độ sáng, thì Deep Fusion lại chụp nhiều bức ảnh để làm tăng độ nét, chi tiết trong bức ảnh. Đây chính là tính năng mà ông Schiller khoe trên sân khấu sự kiện iPhone 11.

Chụp ảnh "siêu phân giải"

So với các smartphone có nhiều camera, chiếc Google Pixel thiếu đi camera tiêu cự lớn, giúp phóng to hình ảnh so với camera thường. Google sử dụng nhiếp ảnh điện toán để giảm bớt sự thua kém.

Tính năng đầu tiên hãng dùng đến thường được gọi là "siêu phân giải". Nó kết hợp quy trình gọi là "demosaicing" và thực tế là tay người chụp thường rung, dù rất nhẹ, khi chụp để thu được nhiều dữ liệu hơn khi chụp.

Nhờ đó, bức ảnh có thể thu được độ phân giải cao hơn, và người dùng có thể "phóng to" mà không cần một ống kính tiêu cự dài. Tất nhiên, chất lượng ảnh không thể so với máy có ống kính xịn.

Google còn giới thiệu một kỹ thuật khác gọi là RAISR. Kỹ thuật này sẽ sử dụng dữ liệu từ hàng triệu bức ảnh trước đó Google đã dùng để đào tạo AI, từ đó suy đoán các chi tiết trong một bức ảnh. Nói cách khác, họ sử dụng AI để nhận biết các khuôn mẫu đã xuất hiện trong những bức ảnh trước.

Nhiếp ảnh điện toán có điểm yếu không?

Nhiếp ảnh điện toán đem lại những bức ảnh vượt quá khả năng thông thường của phần cứng máy ảnh trên smartphone, nhưng không thể phủ nhận chất lượng cảm biến, ống kính vẫn rất quan trọng. Những góc chụp rộng, hẹp cũng có kết quả tốt hơn nếu ống kính hỗ trợ sẵn.

|

| Google mô tả cách hoạt động chung của những tính năng nhiếp ảnh điện toán, như Night Sight trên dòng Pixel. |

Đó là lý do Samsung và Apple trang bị ống kính góc siêu rộng trên những smartphone mới của họ. Khả năng phóng to hàng chục lần trên những smartphone Android cũng khó thực hiện được nếu như Huawei P30 Pro hay Oppo Reno 10X không được trang bị ống kính zoom 5X.

Bên cạnh đó, nhiếp ảnh điện toán thực sự yêu cầu khả năng tính toán rất mạnh mẽ. Điều đó có nghĩa là chỉ những smartphone cao cấp, được trang bị chip riêng cho trí tuệ nhân tạo mới có thể xử lý những tính năng phức tạp trong chốc lát. Nếu không có chip xử lý riêng, việc tối ưu một bức ảnh có thể mất hàng chục giây, và người dùng sẽ không đủ kiên nhẫn để chờ đợi.

Điều chắc chắn là nhiếp ảnh điện toán sẽ ngày càng quan trọng và được tích hợp nhiều hơn trên các smartphone trong tương lai.