|

|

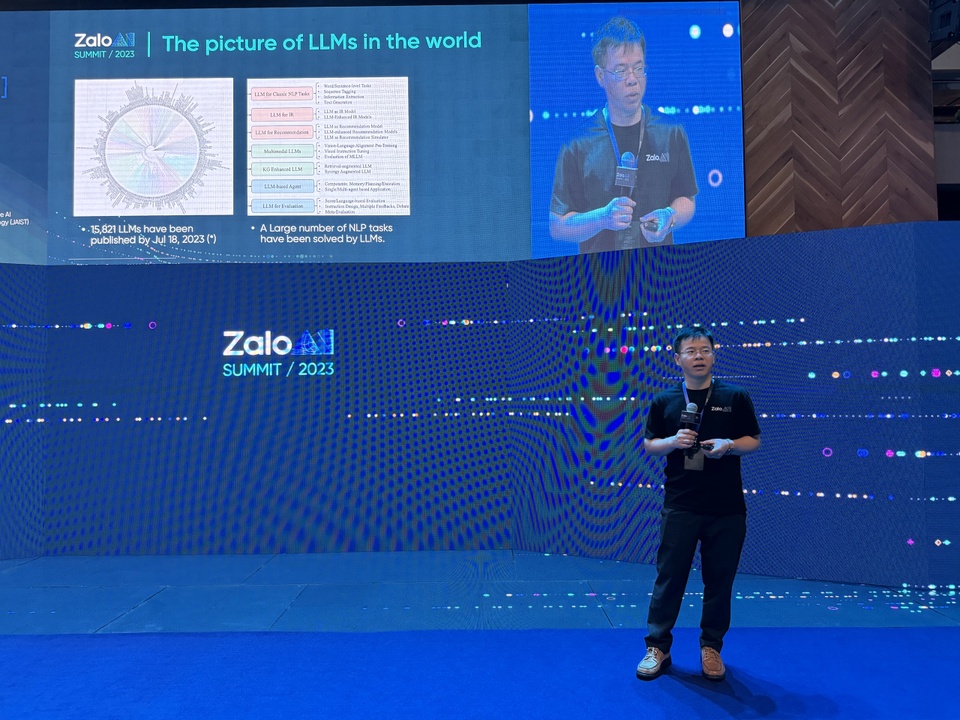

Zalo AI và JAIST hợp tác để phát triển chuẩn này. Ảnh: Phúc Thịnh. |

Ngày 16/12, Zalo AI Summit 2023 đã diễn ra với chủ đề “Trong kỷ nguyên trí tuệ nhân tạo tạo sinh”.

Tại sự kiện, GS. Nguyễn Lê Minh - Giám đốc Trung tâm Nghiên cứu Interpretable AI, Viện Khoa học và Công nghệ Nhật Bản (JAIST) và TS. Châu Thành Đức - Trưởng bộ phận nghiên cứu Zalo AI Lab - đã cùng chia sẻ về sự cần thiết của bộ tiêu chuẩn đánh giá năng lực tiếng Việt (Vietnamese multi-task language understanding - VMLU) trong bối cảnh AI bùng nổ ở Việt Nam.

Thiếu chuẩn chung cho AI Việt

Từ khi ChatGPT ra đời, hàng loạt mô hình ngôn ngữ lớn đã được phát triển ở đa dạng lĩnh vực như y tế, luật pháp, giáo dục... Tính đến tháng 7/2023, nhân loại đón hơn 16.000 mô hình ngôn ngữ lớn ra đời với độ chính xác và hiệu năng ấn tượng. Nhưng để đưa vào thực tiễn ứng dụng, con người cần phải có phương pháp đánh giá những mô hình này, GS. Nguyễn Lê Minh cho biết.

Trên thế giới, đặc biệt là tiếng Anh, nhiều nhóm nghiên cứu đã xây dựng các bộ kiểm định với dataset chuẩn để đánh giá hiệu quả hoạt động của mô hình ngôn ngữ lớn như MMLU, MBPP, GLUE…

|

| Việt NAm còn thiếu bộ tiêu chuẩn đánh giá năng lực tiếng Việt cho các mô hình ngôn ngữ lớn. Ảnh: Phúc Thịnh. |

Ở Việt Nam, mặc dù bài toán phát triển mô hình ngôn ngữ lớn đã có nhiều kết quả nhất định, các nhóm nghiên cứu vẫn chưa có chuẩn chung để đánh giá chúng. Hầu hết đều phải tự xây dựng bộ công cụ đánh giá với chuẩn mực riêng cho mô hình của mình. Đây là những bộ đánh giá nội bộ, chưa được công khai ra thị trường.

“Mỗi lần về Việt Nam hay tìm hiểu những LLM mà Việt Nam phát triển, chúng tôi luôn tự hỏi làm thế nào xác định được nó làm việc hiệu quả hay không?”, GS. Nguyễn Lê Minh đặt vấn đề.

TS. Châu Thành Đức lý giải nguyên nhân Việt Nam chưa có bộ kiểm định LLM riêng là quy trình xây dựng bộ tiêu chuẩn đánh giá tiếng Việt rất khó. Nó đòi hỏi lượng dữ liệu đủ bao quát và có tính ý nghĩa thống kê. Đại diện Zalo AI Lab chia sẻ thêm khó khăn thứ 2 là nguồn cấp dữ liệu. Các câu hỏi trong dataset dùng để kiểm định không được trùng với dữ liệu LLM đã học.

“Mình cần phải tìm ra bộ dữ liệu mà các mô hình không có. Như vậy, thước đo kiểm định mới chuẩn xác và công bằng. Dữ liệu càng ít xuất hiện trên Internet càng tốt nhưng chất lượng phải được đảm bảo”, ông Đức cho biết.

Cần có tiêu chuẩn đánh giá năng lực tiếng Việt chung cho hàng chục nghìn LLM

Những trăn trở này đã thúc đẩy Zalo AI và JAIST hợp tác tạo ra một cơ sở đánh giá các LLM tiếng Việt - được gọi là VNHSGE (Vietnamese High School Graduation Examination) dataset. Đây là một trong 3 nền tảng quan trọng của VMLU.

Bộ dữ liệu VNHSGE bao gồm 10.880 câu hỏi trắc nghiệm xoay quanh 58 chủ đề khác nhau. Mỗi chủ đề có khoảng 200 câu hỏi trắc nghiệm và được phân bổ trên 4 lĩnh vực bao gồm: STEM, Khoa học xã hội, Khoa học nhân văn và một danh mục “Mở rộng”.

|

| LLM là chủ đề chính trong Zalo Summit 2023. Ảnh: Zalo. |

Bộ dataset được lấy từ các đề thi thật kèm đáp án chính thức, sau đó tiếp tục được người thật xác minh để đảm bảo tính tin cậy và khoa học. “Để tạo ra một bộ dữ liệu chuẩn xác với gần 11.000 câu hỏi là một điều rất khó khăn. Vì vậy, nhóm nghiên cứu phải làm việc rất nhiều tháng mới hoàn thành”, TS. Đức chia sẻ.

Nhưng chỉ bộ dataset đa dạng thôi chưa đủ, VMLU còn bao gồm chuẩn đánh giá (benchmark) và bảng xếp hạng (leaderboard), làm cơ sở để kiểm tra, so sánh với các mô hình AI ứng dụng ngôn ngữ Việt. Theo Trưởng bộ phận nghiên cứu Zalo AI, VMLU sẽ chấm điểm kết quả theo 2 cách: hoặc dùng ký tự A, B, C, D để trả lời, hoặc tính xác suất gần nhất với đáp án chuẩn. Sau khi có kết quả đánh giá, các nhóm nghiên cứu có thể lựa chọn công khai điểm trên bảng xếp hạng chung hoặc không.

Bảng xếp hạng cũng được chia theo 4 lĩnh vực là STEM, Khoa học xã hội, Khoa học nhân văn và Mở rộng. Với những nhóm nghiên cứu sử dụng VLMU, họ có thể nhận bảng kết quả đầy đủ bao gồm điểm cho từng môn học.

Điểm sáng của VMLU là có thể đọc hiểu tiếng Việt, bao quát một lượng kiến thức rộng lớn nhằm kiểm định LLM quy mô dữ liệu từ nhỏ đến lớn. Bên cạnh đó, bộ dataset của Zalo AI và JAIST cũng bao gồm một số câu hỏi đòi hỏi tính suy luận nhưng mới chỉ ở mức độ sơ khai, chưa phức tạp. Vì thế, VMLU sẽ là cơ sở để các nhóm phát triển LLM đánh giá mô hình của mình, đúc kết điểm mạnh, điểm yếu kiến thức, từ đó hoàn thiện hơn.

|

| Các nhóm nghiên cứu có thể tự đánh giá mô hình của mình miễn phí bằng VLMU. Ảnh: VLMU. |

Hai chuyên gia đặt kỳ vọng bộ tiêu chuẩn đánh giá tiếng Việt sẽ trở thành một thứớc đo chung cho cộng đồng AI Việt. “Chúng tôi hy vọng VLMU sẽ là một chuẩn mực để giúp các các nhóm phát triển mô hình ngôn ngữ cho tiếng Việt có cái nhìn chung nhất về lĩnh vực hoặc là một kênh các bạn có thể tham khảo”, GS. Nguyễn Lê Minh chia sẻ.

Song, vấn đề đặt ra là liệu VLMU có thể đánh giá toàn bộ hoạt động thực tế của các LLM hay không? “Câu trả lời là không”, TS. Châu Thành Đức nói. Bộ tiêu chuẩn đánh giá năng lực tiếng Việt hiện vẫn bị giới hạn bởi hình thức câu hỏi trắc nghiệm, không hiệu quả khi gặp những câu hỏi không biểu diễn dưới dạng đáp án A, B, C, D như viết lách, gõ code…

Mặc dù VMLU có thể đánh giá kiến thức trên khá nhiều lĩnh vực, điều đó không có nghĩa là nó phản ánh được mọi thứ. “Tùy theo kỹ năng, khía cạnh của LLM cần đánh giá, chúng ta sẽ dùng VMLU với mục đích tương ứng”, chuyên gia cho biết.

Trưởng bộ phận nghiên cứu Zalo AI Lab cũng kêu gọi mọi người sử dụng VMLU và cùng nhau đóng góp để tạo ra bộ đánh giá ngày càng hoàn hiện. Trong đó, Zalo AI Challenge cũng là một hoạt động hướng về cộng đồng, giúp lĩnh vực AI tại Việt Nam phát triển hơn. “Phát triển LLM là một hành trình rất dài và chúng ta chỉ có thể làm được nếu liên kết và hợp tác cùng nhau”, đại diện Zalo chia sẻ.

Những câu hỏi chúng ta phải đối mặt trong thế giới AI

Chúng ta có rất nhiều câu hỏi về thế giới AI, mà đó đều là những nghi hoặc không dễ có ngay đáp án.

Cuốn sách Thời đại AI - Và tương lai loài người chúng ta trình bày cách AI làm thay đổi mối quan hệ của chúng ta với tri thức, chính trị và xã hội. Mục tiêu tối thượng của cuốn sách này là giải thích về AI và cung cấp cho độc giả những câu hỏi mà chúng ta sẽ phải đối mặt trong những năm tới lẫn bộ công cụ để bắt đầu trả lời chúng.