Tối 18/2, tại hội nghị các nhà phát triển ở San Jose, Nvidia đã chính thức công bố thế hệ chip AI mới kế thừa H100 - con chip luôn "cháy hàng" năm 2023.

Cụ thể, kiến trúc thế hệ bộ xử lý đồ họa AI mới sẽ có tên Blackwell. Theo CNBC, lô chip Blackwell đầu tiên có tên GB200 sẽ xuất xưởng vào cuối năm nay.

Theo tiết lộ từ ông lớn sản xuất chip, các bộ xử lý dựa trên kiến trúc Blackwell, như GB200 mang lại sự nâng cấp hiệu suất rất lớn cho các doanh nghiệp ứng dụng AI.

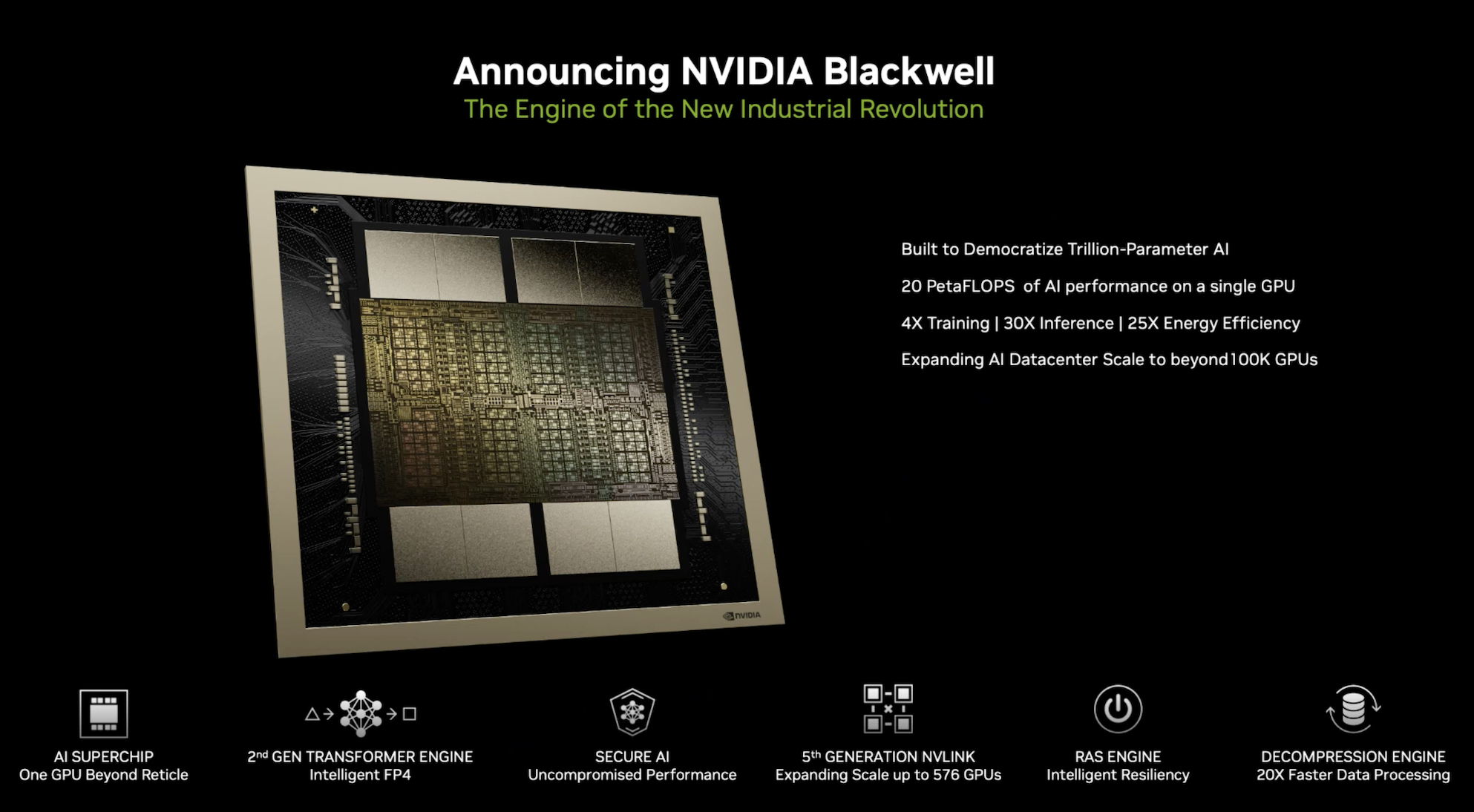

Cụ thể, khả năng tính toán của GB200 là 20 petaflop, lớn gấp 5 lần so với con số 4 petaflop của H100. Nvidia cho biết sức mạnh xử lý bổ sung này sẽ cho phép các công ty AI đào tạo mô hình lớn và phức tạp hơn.

Theo Nvidia, trong xử lý thực tế, GB200 có thể nhanh gấp 7-30 lần H100 ở các tác vụ, trong khi giảm điện năng tiêu thụ tới 25 lần.

"Đũa thần" mới của giới công nghệ

Theo chu kỳ hai năm một lần, Nvidia sẽ cập nhật kiến trúc GPU với mục đích mang lại bước nhảy vọt lớn về hiệu suất.

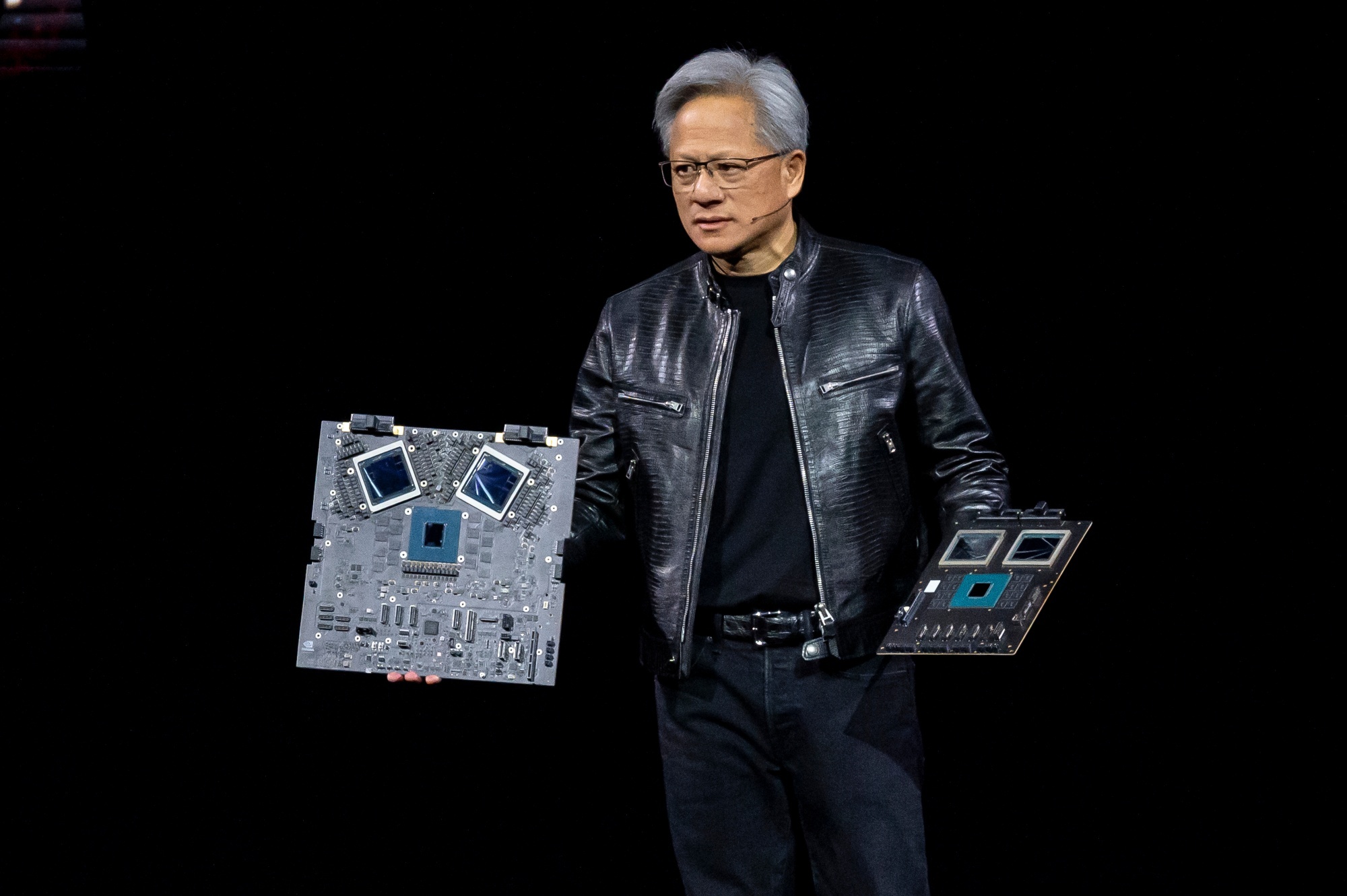

“Kiến trúc Hopper thật tuyệt vời, nhưng chúng tôi cần một GPU lớn hơn”, CEO Nvidia Jensen Huang cho biết.

Năm 2022, kiến trúc Hopper, được đặt theo lập trình viên nổi tiếng trong lịch sử Mỹ Grace Hoppe, đã gây nên cơn sốt toàn cầu.

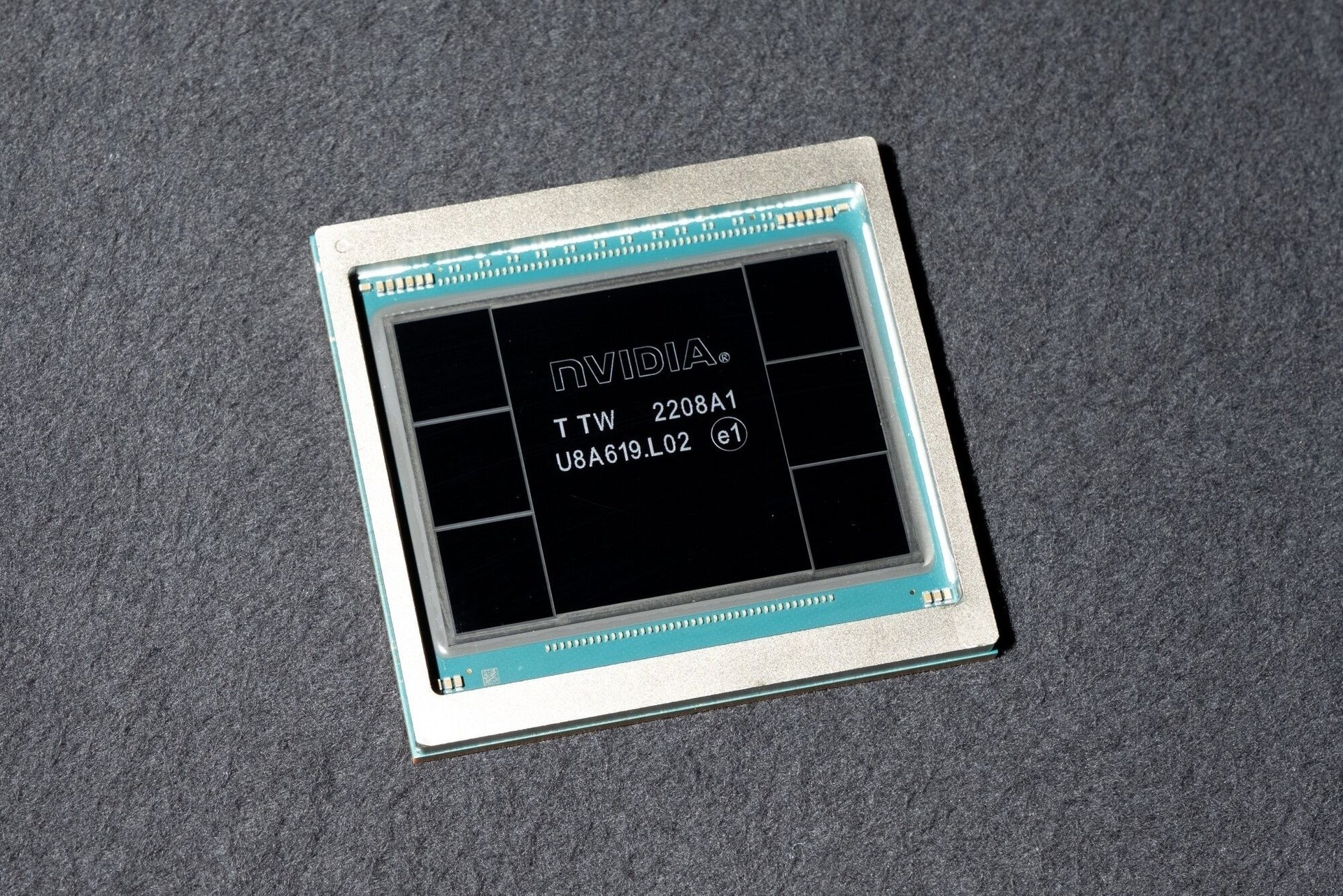

|

| H100 của Nvidia, có giá hơn 40.000 USD và liên tục cháy hàng. Ảnh: Bloomberg. |

H100, bộ vi xử lý mạnh mẽ nhất mà Nvidia từng chế tạo dựa trên kiến trúc Hopper. Đây cũng là bộ vi xử lý đắt đỏ nhất trong lịch sử công ty, với giá thành lên tới 40.000 USD cho mỗi một đơn vị.

Ban đầu, việc ra mắt được đánh giá là không đúng thời điểm, trong bối cảnh các doanh nghiệp ngành bán dẫn tìm cách cắt giảm chi tiêu khi lạm phát gia tăng.

Đến tháng 11/2022, chatbot mang tên ChatGPT được ra mắt và tạo cơn sốt toàn cầu. Khi đó, Nvidia đã “bước chân” sang lĩnh vực trí tuệ nhân tạo. Tầm nhìn của những người đứng đầu Nvidia một lần nữa lại đi trước thời đại.

Với H100, Nvidia trở thành công ty trị giá 2.000 tỷ USD nhờ cung cấp những con chip quan trọng, dùng để huấn luyện các mô hình trí tuệ nhân tạo (AI) phức tạp.

Sự thành công vượt bậc của Hopper đã khiến giới công nghệ trông chờ thế hệ kiến trúc mới mà Nvidia công bố.

Theo CNBC, GPU Blackwell có kích thước lớn và kết hợp hai khuôn được sản xuất riêng biệt thành một con chip do TSMC sản xuất.

Một trong những công nghệ cốt lõi làm nền tảng cho ChatGPT là động cơ biến áp cũng sẽ xuất hiện trên GB200.

|

| Thông số ấn tượng của kiến trúc Blackwell mới. Ảnh: Nvidia. |

Hãng cũng đã tích hợp con chip AI mới nhất này dưới dạng toàn bộ máy chủ có tên GB200 NVLink 2, kết hợp 72 GPU Blackwell và các bộ phận Nvidia khác được thiết kế để đào tạo các mô hình AI.

Amazon, Google, Microsoft và Oracle sẽ là những nhà cung cấp đầu tiên các phiên bản của Blackwell thông qua nền tảng đám mây. Phía Nvidia cũng tiết lộ Amazon Web Services sẽ xây dựng một cụm máy chủ với 20.000 chip GB200.

Hứa hẹn những đột phá mới của AI

Nvidia cho biết hệ thống này có thể triển khai mô hình lên tới 27.000 tỷ tham số. Con số này lớn hơn nhiều so với cả những mẫu lớn nhất, chẳng hạn như GPT-4 được cho là có 1.700 tỷ thông số.

Nhiều chuyên nghiên cứu AI tin rằng với nhiều thông số và dữ liệu hơn, các mô hình ngôn ngữ lớn (LLM) trong tương lai áp dụng con chip này sẽ có thể mở ra đột phá mới.

Hiện nhà sản xuất này vẫn chưa tiết lộ giá bán của GB200 hoặc các hệ thống sử dụng nó. Theo ước tính của các nhà phân tích, thế hệ H100 dựa trên kiến trúc Hopper có giá từ 25.000 - 40.000 USD mỗi chip, trong khi toàn bộ hệ thống tích hợp GPU này có giá lên tới 200.000 USD.

|

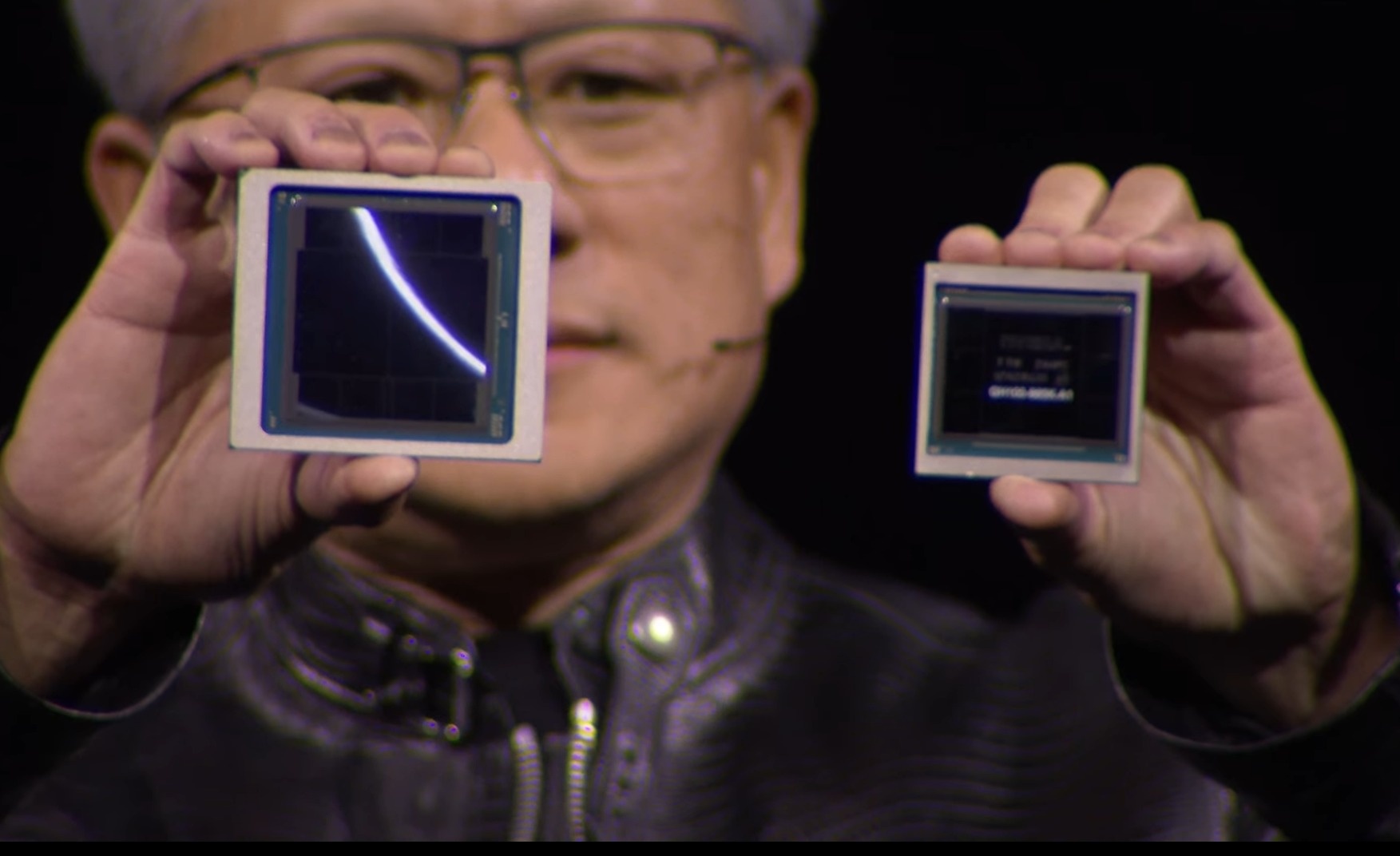

| Cận cảnh kích thước hai con chip GB200 (trái) và H100 (phải). Ảnh: Nvidia. |

Tuy có giá bán khá cao, nhu cầu về H100 vẫn lớn đến mức một số khách hàng phải đợi tới 6 tháng mới nhận được hàng.

Bên cạnh GPU mới, Nvidia cũng giới thiệu phần mềm có tên NIM - một tập hợp các dịch vụ điện toán đám mây được thiết kế tối ưu hóa để rút ngắn thời gian tiếp thị và đơn giản hóa việc triển khai các mô hình AI tạo sinh ở mọi nơi.

CNBC phân tích NIM cho phép các công ty chạy mô hình AI của riêng họ, thay vì phải mua quyền truy cập vào kết quả AI dưới dạng dịch vụ từ các bên thứ 3 như OpenAI.

Nvidia sẽ làm việc với các công ty AI như Microsoft hay Hugging Face để đảm bảo các mô hình AI của họ được điều chỉnh để chạy trên tất cả chip Nvidia tương thích.

Sau đó, với NIM, các nhà phát triển có thể chạy mô hình một cách hiệu quả trên máy chủ của riêng họ hoặc máy chủ Nvidia trên đám mây mà không cần trải qua quá trình cấu hình hệ thống kéo dài.

Một ưu điểm khác của phần mềm này là đối tác có thể chạy AI trên laptop được trang bị GPU của Nvidia, thay vì phải cố định ở các máy chủ trên đám mây.

Dùng ChatGPT thế nào để không tạo ra nội dung vô tri

Sự phát triển của AI mở ra nhiều tiềm năng nhưng cũng có không ít mối lo đối với ngành xuất bản, đặc biệt là nhóm tác giả viết sách.

Các tác giả sách cần phải chấp nhận sự vươn lên của AI, sử dụng chúng như một "siêu trợ lý" thay vì chối bỏ trào lưu. Chia sẻ với Tri thức - Znews, nhiều cây viết cho rằng người làm sách vẫn có thể đứng vững trong thời đại AI nếu biết cách tận dụng sức mạnh của trí tuệ nhân tạo.